- Registriert

- 09.04.20

- Beiträge

- 3.464

- Reaktionen

- 2.508

- Punkte

- 11.074

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: Diese Funktion ist in einigen Browsern möglicherweise nicht verfügbar.

Nun, Logic hat (oder hatte?) einen PDC Latenz Automations-Bug über Sidechains und Auxe, bei grösseren verschachtelten Projekten wohl festzustellen. Sowas hat dann wirklichen Einfluss.Wie sieht es eigentlich mit dem Verhalten der DAWs beim z.B. rendern von Softwareinstrumenten aus, oder bei der Berechnung von algo. Reverbs usw.? Klingen diese dann immer noch so gleich, dass man den Nulltest machen kann?

www.logicprohelp.com

www.logicprohelp.com

Ja daran dachte ich auch, das taugt dann nicht zum Vergleich, da es selbst in der einen DAW immer anders klingen würde.oder etwaige Analog-Emulationen

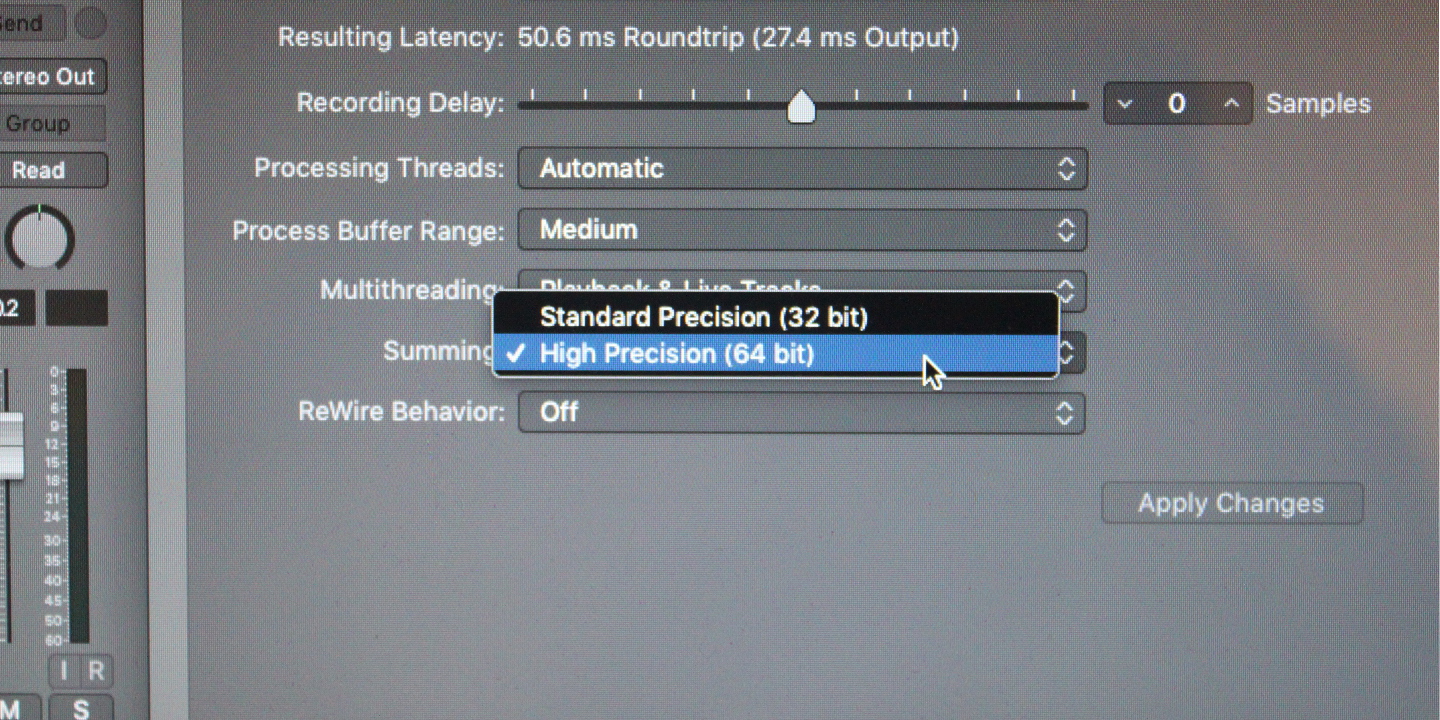

Wie schaut's eigentlich mit der ITB Summierung, also multiple Audiosignale über Gruppen zusammengefaßt, innerhalb der DAWs aus?

Soweit ich mich vage erinnere, sollte selbst das bei allen gleich sein, da reine Mathematik? wer weiss etwas darüber und kann gezielt dies mal aufklären?

Wie sieht es eigentlich mit dem Verhalten der DAWs beim z.B. rendern von Softwareinstrumenten aus, oder bei der Berechnung von algo. Reverbs usw.? Klingen diese dann immer noch so gleich, dass man den Nulltest machen kann?

is halt weniger sexy

is halt weniger sexy

alles längst durchgenulltestet.Wie schaut's eigentlich mit der ITB Summierung, also multiple Audiosignale über Gruppen zusammengefaßt, innerhalb der DAWs aus?

Soweit ich mich vage erinnere, sollte selbst das bei allen gleich sein, da reine Mathematik? wer weiss etwas darüber und kann gezielt dies mal aufklären?

Sicher, sicher. Mich interessierte gerade da ja vielmehr, wie sowas rechnerisch gelöst wird und was ist da unter der Haube los beim ITB Summieren, wenn z.B. 1024 Audiosignale da in einen Gruppenkanal zusammenkommen?alles längst durchgenulltestet.

Es ist Sonntag, für mehr als die ohnehin schon knifflige Frage, ob ich nun als erstes einen doppelten Espresso ohne alles oder doch einen Americano trinken will, habe ich heute keinen headroom freiwer weiss etwas darüber und kann gezielt dies mal aufklären?

Das ist sehr bedauerlich, aber wohl gerade nicht zu ändern. Danke Dir trotzdem f. d. Infos!Am wenigsten habe ich Lust, mein sehr tief vergrabenes weil ungeliebtes Schulhalbwissen in DSP-Programmierung rauszukramen.

niemals.Wenn du dich gern selber ein wenig quälen möchtest

Du übergehst hier aber die 320ms bei Studio One.das video könnte man auch so zusammenfassen:

wenn man einen harten mute automatisiert, clicken manche daws, und andere machen stattdessen einen ultrakurzen fade (2ms) oder einen "langen" kurzen fade (20ms)

joah...whatever? da bin ich ganz froh, dass meine zu denen mit ultrakurzen fades aber ohne click-artefakt gehört, aber...who cares.

dass allerdings die daws, die einen click artefakt produzieren, im video als die besonders ordentlichen gelobt werden ist ehrlich gesagt herzlich praxisfremd.

und mit klang hats halt immer noch nix zu tun. nur mit klicks.

im doppelten sinne (har!)

Was war da?Du übergehst hier aber die 320ms bei Studio One.

Bezog sich auf das Video aus meinem vorherigen post, ab ca. 3:30. Damals gabs bei Studio One scheinbar einen Bug, bei dem die volume Automation in einem 320ms fade endete. Ist aber bestimmt seitdem gepatcht.Was war da?

Mit Vst3 sollte es theoretisch solche Automationsprobleme nicht geben, weil Vst3 angeblich samplegenau automatisieren kann. Hast du Vst3 verwendet oder hast du die Tracklautstärke in Studio One automatisiert? Auch dann sollte die automation theoretisch samplegenau funktionieren. Tut es aber meistens nicht.Was die 20ms betrifft, ich hab mal einen kleinen Test gebaut:

your_browser_is_not_able_to_play_this_audio

Hier gibt es einen kleinen Stuttereffekt über eine volume Automation. Zuerst mit einer steilen Flanke und dann mit einer 20ms linearen flanke. Der Unterschied ist schon deutlich hörbar.

Bei 120BPM sind 20ms eben schon auf der größenordnung von 1/32.

In meinem Beispiel wars jetzt eine Track Volume Automation in Reaper.Mit Vst3 sollte es theoretisch solche Automationsprobleme nicht geben, weil Vst3 angeblich samplegenau automatisieren kann. Hast du Vst3 verwendet oder hast du die Tracklautstärke in Studio One automatisiert? Auch dann sollte die automation theoretisch samplegenau funktionieren. Tut es aber meistens nicht.

Bei 1024 Einzelspuren wird das Fehlerpotential beim Umwandeln von FP schon deutlich höher.

Wenn deine DAW (Cubase oder?) samplegenau automatisieren würde, wäre es ja kein Problem bei einer harten Muteautomation, die dann einen Click verursacht, selber einen kleinen Fade einzuzeichnen, damit der Click verschwindet oder aber, dass du alternativ in den Programmeinstellungen selber eine Fadelänge einstellen könntest. In Reaper geht das glaube ich sogar. Cubase scheint mir dagegen generell etwas altbacken, langsam und ungenau zu sein auch wenn die Cubase-Fanboys sich raus reden und was anderes behaupten. Von wegen, das ist alles Quatsch und überhaupt nicht relevant.das video könnte man auch so zusammenfassen:

wenn man einen harten mute automatisiert, clicken manche daws, und andere machen stattdessen einen ultrakurzen fade (2ms) oder einen "langen" kurzen fade (20ms)

joah...whatever? da bin ich ganz froh, dass meine zu denen mit ultrakurzen fades aber ohne click-artefakt gehört, aber...who cares.

dass allerdings die daws, die einen click artefakt produzieren, im video als die besonders ordentlichen gelobt werden ist ehrlich gesagt herzlich praxisfremd.

und mit klang hats halt immer noch nix zu tun. nur mit klicks.

im doppelten sinne (har!)

Was diese unsicheren uninformierten Leute für Fake News schreiben, haha, guter Versuch. ^^Cubase scheint mir dagegen generell