Schlumpfpeter

Loudness-Opfer

- Registriert

- 23.06.10

- Beiträge

- 18.368

- Reaktionen

- 13.337

- Punkte

- 58.574

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: Diese Funktion ist in einigen Browsern möglicherweise nicht verfügbar.

Mit insgesamt 10 ms Latenz kann man eigentlich schon arbeiten, klar geht es besser.Focusrite USB 2.0 Driver

Buffer size im Fokusrite Scarlett ist 10.0 ms

Direkt reinspielen heisst, wenn ich zB mit dem Bass trocken direkt in das Scarlett reingehe und spiele, habe ich keine spürbare Latenz, und auch die Aufnahme ist nahezu latenzfrei. Wenn ich aber bei der Aufnahme ein Plugin verwende, zB ein GitarrenAmp VST, dass ich dann auch bei spielen hören will, dann habe ich Latenz, da ich dann auch scheiße spiele und die Aufnahme hin ist, ist klar

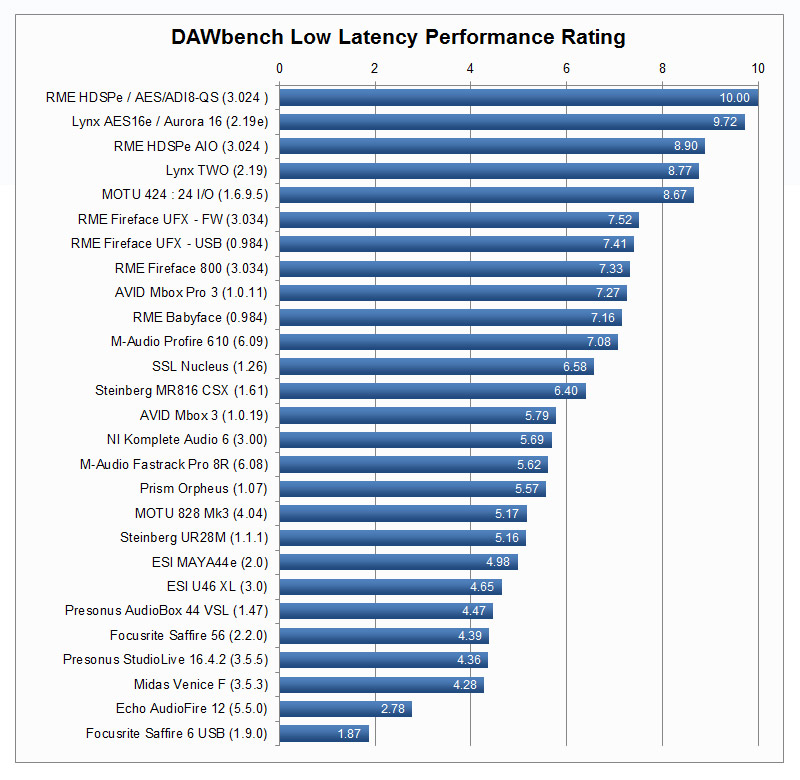

kein Plan wie die Scarlett oder Focusrite generell abschneiden würde, aber bei diesem Daw Bench liegen die Focusrite Geräte weit hinten und belegen sogar den letzten Platz.

https://www.dawbench.com/audio-int-lowlatency2.htm

Wenn ich aber bei der Aufnahme ein Plugin verwende, zB ein GitarrenAmp VST, dass ich dann auch bei spielen hören will, dann habe ich Latenz, da ich dann auch scheiße spiele und die Aufnahme hin ist, ist klar

Wozu was runterladen und installieren.

In den wohl meisten DAWs kann man das direkt ablesen, man braucht nur Input Latency und Output Latency addieren = RTL* (*Round Trip Latency)

Nö. Es läuft über (Asio)Treiber, diese Werte werden exakt ermittelt und in der DAW dargestellt. Das kann man ja nicht "faken". RTL ist dann nun mal RTL.gerade bei günstigeren Interfaces werden hier nicht die korrekten Werte übermittelt.

Wie gesagt, das benötigt man nicht zwingend. Die Anzeigen in der DAW sind für die meisten ausreichend.Deshalb gibt es dieses Tool auch überhaupt nur.

Wäre interessant zu wissen, wie die DAW's das realisieren. Logic zeigt jedenfalls die Latenzwerte an, die vom Interface/Treiber übermittelt werden. Deswegen gibt es ja zusätzlich den Anpassungsregler - der wäre ja sonst hinfällig.In den wohl meisten DAWs kann man das direkt ablesen,

Tja - diese Technik gibt es am Mac wohl nicht ... wie man das aus dem Stand (ohne Loopback) ermitteln könnte, ist mir unklar.Es läuft über Asio-Treiber, diese Werte werden exakt ermittelt und dargestellt.

Ob günstig oder teuer - in Logic tauchen immer wieder mal Probleme mit Unterschieden zwischen angegebener und tatsächlicher Latenz auf.Ansonsten, beweise deine Aussage doch einfach mal schön hier, in Sachen günstige Wandler und totale Verfälschungen.

Stimmt.Mininmalste Toleranzen dürften eh nicht relevant sein.

Dies!die andere Frage ist, wie genau man das wissen muss. Mir persönlich ist der Wert, der da steht, genau genug.

"Wir" schon mal gar nicht... ^^Bereich (wir reden hier durchaus von 5+ms).

Ich befürchte, diese Anrede wird zu (mindestens) 90% falsch verstanden:Allerwertester!

Da haben wir beide recht. Der potenzielle Versatz resultiert oft aus einem falsch übermittelten Latenzwert.der Anpassungsregler im Logic hat eigentlich nichts mit der Latenz zu tun (wenn wir von dem im Treibermenü reden), sondern dient dazu, einen potentiellen Aufnahmeversatz auszugleichen.