- Registriert

- 30.09.08

- Beiträge

- 15.481

- Reaktionen

- 8.808

- Punkte

- 42.268

Warum? Letztendlich ist doch alles berechenbar.Und jetzt aber ein Gesamtes quasi aus dem Nichts zu erstellen scheint mir vom Rechenprozess her noch unbegreiflicher.

Töne bestehen aus Frequenzen und wir als Musiker nutzen das tagtäglich. Die Gitarre stimmen wir meist auf a 440Hz.

Davon ausgehend hat man schon die Möglichkeit die Harmonielehre abzuleiten.

Instrumente bestehen aus Obertönen. Die sind halt auch wichtig für die Erkennung eines Instruments.

FM-Synthese ist z.B. für mich auch unbegreiflich, aber Du kannst daraus auch so jeden Sound basteln den es gibt.

Die zeitliche Komponente wie lange etwas ausklingt, hatten wir auch schon. Gehört auch irgendwie dazu.

Desweiteren kann ich es mir auch als eine Art von Spectralanalyse vorstellen. Da kannst Du ja sogar selbst etwas weg- oder hinzufügen.

Ich hatte irgendwo gelesen, dass man anfangs viel mit Midi experimentiert hat, weil dort die Daten kleiner gehalten werden konnten.

AIVA sei genannt. Das gibt es schon ein paar Jahre.

Audio to Midi gibt es z.B. auch nicht erst seit gestern. Andersherum genauso.

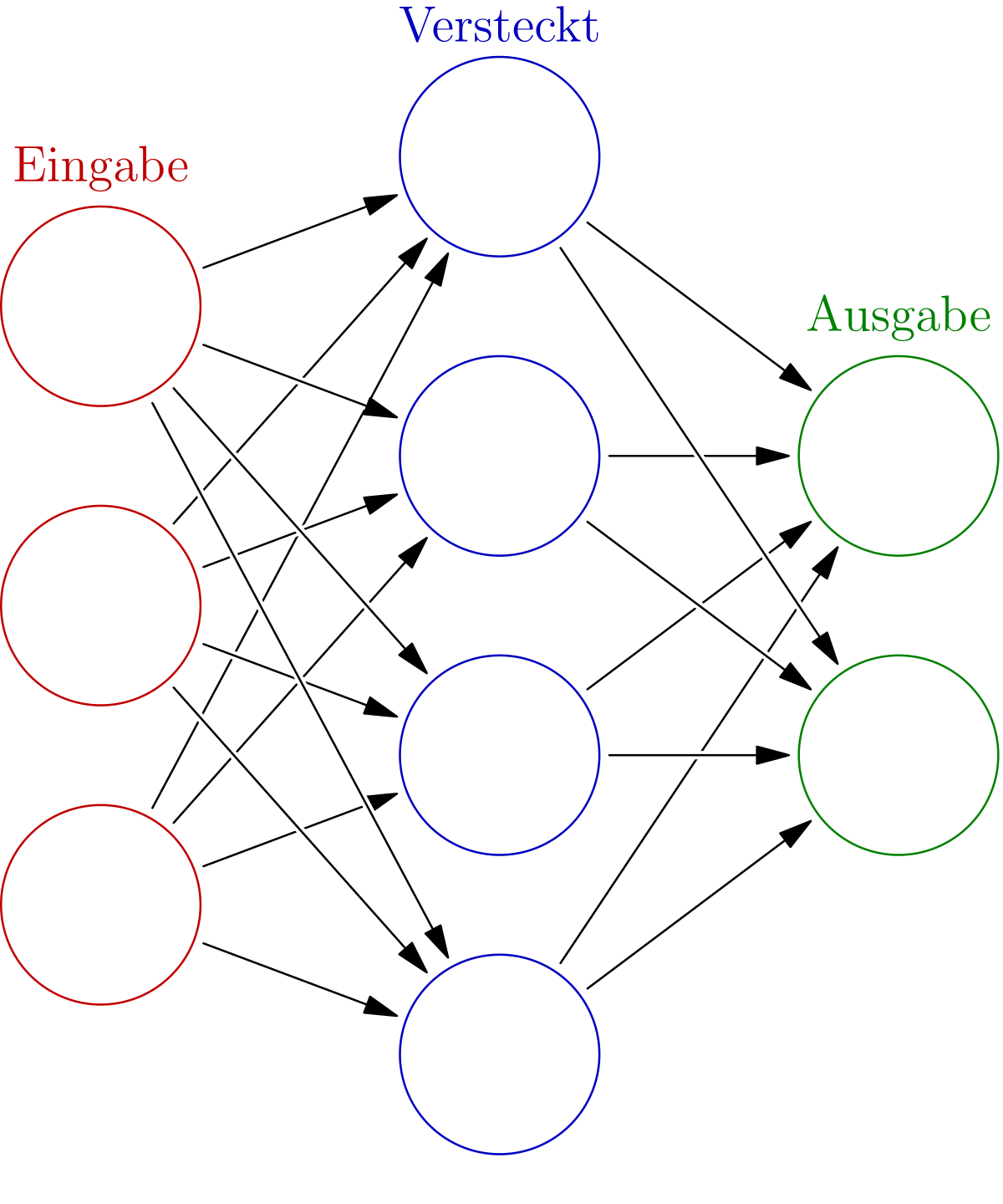

Mit dem neuronalen Netzwerken ist es genauso. Das ist halt inspiriert von unseren biologischen Neuronen im Gehirn.

Und das unser Gehirn ein Wunderwerk ist, wissen wir ja alle. Das finde ich zumindest unbegreiflich.

Hier nochmal näher erklärt, was Schludi meint.

Künstliche neuronale Netze basieren meist auf der Vernetzung vieler McCulloch-Pitts-Neuronen oder leichter Abwandlungen davon. Die Topologie eines Netzes (die Zuordnung von Verbindungen zu Knoten) muss im Hinblick auf seine Aufgabe gut durchdacht sein. Nach der Konstruktion eines Netzes folgt die Trainingsphase, in der das Netz „lernt“. Theoretisch kann ein Netz durch folgende Methoden lernen:

- Entwicklung neuer Verbindungen

- Löschen existierender Verbindungen

- Ändern der Gewichtung (der Gewichte der Verbindung w i j

von Neuron jzu Neuron i)

- Anpassen der Schwellenwerte der Neuronen, sofern diese Schwellenwerte besitzen

- Hinzufügen oder Löschen von Neuronen

- Modifikation von Aktivierungs-, Propagierungs- oder Ausgabefunktion

Außerdem verändert sich das Lernverhalten bei Veränderung der Aktivierungsfunktion der Neuronen oder der Lernrate des Netzes. Praktisch gesehen „lernt“ ein Netz hauptsächlich durch Modifikation der Gewichte der Verbindungen zwischen den Neuronen. Eine Anpassung des Schwellenwertes kann hierbei durch ein on-Neuron miterledigt werden. Dadurch sind KNNs in der Lage, komplizierte nichtlineare Funktionen über einen „Lern“-Algorithmus, der durch iterative oder rekursive Vorgehensweise aus vorhandenen Ein- und gewünschten Ausgangswerten alle Parameter der Funktion zu bestimmen versucht, zu erlernen. KNNs sind dabei eine Realisierung des konnektionistischen Paradigmas, da die Funktion aus vielen einfachen gleichartigen Teilen besteht. Erst in ihrer Summe kann deren Verhalten im Zusammenspiel sehr vieler beteiligter Teile komplex werden. Ein neuronales Netz, das deterministisch beschrieben wird und Rückkopplungen erlaubt, stellt unter dem Gesichtspunkt der Berechenbarkeit ein äquivalentes Modell zur Turingmaschine dar.[5] D.h. zu jedem Netz gibt es mindestens eine Turingmaschine und zu jeder Turingmaschine gibt es mindestens ein Netz mit Rückkopplung. Bei einer stochastischen Beschreibung ist dies nicht der Fall. Rekurrente Netze sind damit die ausdrucksstärkste Form (Typ 0 in der Chomsky-Hierarchie).