Dann merke ich hab ichs noch nicht ganz verstanden. Ich dachte die Latenz sei ein Ausdruck dafür wieviel CPU Zeit verbraucht wird, und um diesen Faktor verzögert sich die Ausgabe des Tons.

In der Buffersize gibst du nur an wie gross die Häppchen sind die gerade verarbeitet werden können.

Die Soundausgabe braucht dann immer die Zeit der Häppchen .

1/fs*buffersize=latenz der Soundausgabe.

Bei 44100Hz Abtastrate (fs) werden 44100 Samples in der Sekunde ausgegeben.

1s/44100Samples*128Samples=0,0029s=2,9ms braucht der Buffer zur Verarbeitung.

In dieser Zeit ist es natürlich schwieriger für die CPU mehr Rechenoperationen auszuführen als wenn die Verarbeitungszeit länger wäre (grössere Buffersize).

Die Pluginlatenz ist dann noch die Zeit die du auf die Soundausgabezeit rechnen musst.

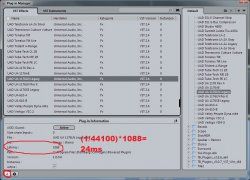

Beim UAD 1176 sind das 1088 Samples oder ca 24ms.

So lange braucht das Plugin für die Rechenoperation.

Cubase muss das Audio welches nicht von einem Effekt verzögert wird also so lange warten lassen bis das Plugin welches am längsten braucht fertig ist und es dann ausgeben.

Hat man allerdings mehrere Plugins nacheinander muss man immer wieder die Zeit dazurechnen.

Sind die Plugins Parallel auf den Spuren verteilt gibt immer das Plugin mit der höchsten Latenz die Verzögerung vor.

Der Grund warum Cubase die Midievents zeitlich korrigiert ist eigentlich ganz einfach.

Du hörst das Backing evtl ohne Effekte auf einer Audiospur.

Jetzt hast du einen Synthesizer auf dem viele latenzbehaftete Plugins liegen-> du hörst die Soundausgabe verzögert.

Du selbst versuchst jetzt die Latenz auszugleichen und spielst die Note früher an um auf den Punkt zu kommen.

Demnach wird die Note früher aufgenommen, das versucht Cubase auszugleichen indem die Note um den Latenzwert der Plugins nach der Aufnahme nach hinten korrigiert wird.

?

?