- Registriert

- 18.06.08

- Beiträge

- 914

- Reaktionen

- 734

- Punkte

- 3.155

Hallo,

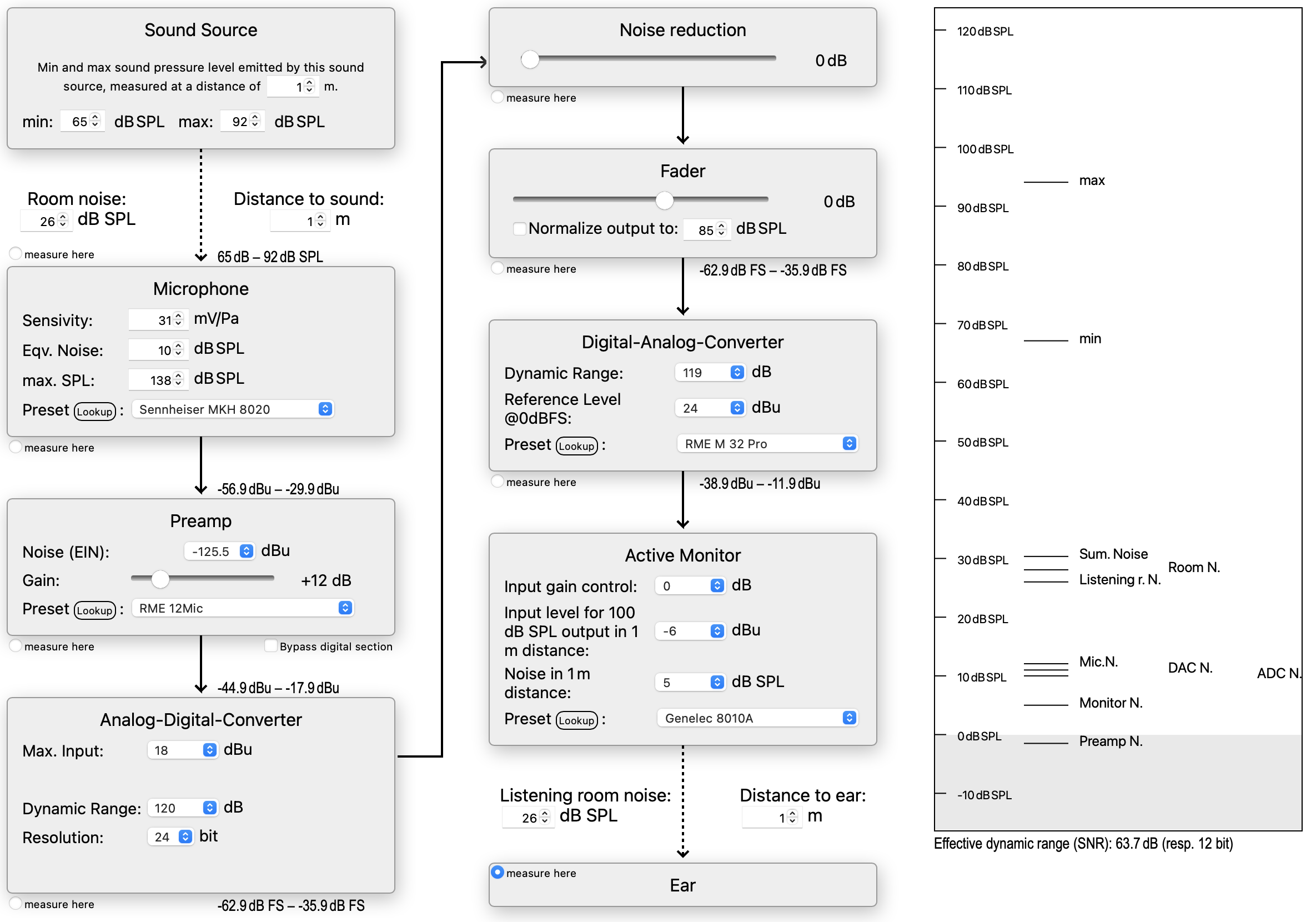

ich hatte bereits ein kleines Online-Tool programmiert, nun habe ich es deutlich erweitert: es zeigt den Verlauf des Klangs von der akustischen Erzeugung bis zur Wiedergabe über die Boxen, mit den Zwischenstationen Mikrofon, Preamp, ADC, DAC... und berechnet allerlei technische Werte sowie die Rauschanteile und wie diese sich summieren, in Abhängigkeit diverser Parameter der beteiligten Gerätschaften und Einstellungen (bit-Auflösung, Gain, Fader).

Zwar ist das Ohr das wichtigste Werkzeug des Tonmachers, aber manch visueller Eindruck kann für das Verständnis einiger Zusammenhänge ganz erhellend sein. Beispielsweise erkennt man, dass das Einpegeln unter realistischen Umständen weit weniger kritisch ist als oft vermutet. Ebenso ist eine digitale Lautstärkeregelung vor (statt nach) dem DAC meist unproblematischer für die Klangqualität als gemeinhin befürchtet.

Wer Lust hat, damit ein bißchen herumzuspielen, hier entlang.

ich hatte bereits ein kleines Online-Tool programmiert, nun habe ich es deutlich erweitert: es zeigt den Verlauf des Klangs von der akustischen Erzeugung bis zur Wiedergabe über die Boxen, mit den Zwischenstationen Mikrofon, Preamp, ADC, DAC... und berechnet allerlei technische Werte sowie die Rauschanteile und wie diese sich summieren, in Abhängigkeit diverser Parameter der beteiligten Gerätschaften und Einstellungen (bit-Auflösung, Gain, Fader).

Zwar ist das Ohr das wichtigste Werkzeug des Tonmachers, aber manch visueller Eindruck kann für das Verständnis einiger Zusammenhänge ganz erhellend sein. Beispielsweise erkennt man, dass das Einpegeln unter realistischen Umständen weit weniger kritisch ist als oft vermutet. Ebenso ist eine digitale Lautstärkeregelung vor (statt nach) dem DAC meist unproblematischer für die Klangqualität als gemeinhin befürchtet.

Wer Lust hat, damit ein bißchen herumzuspielen, hier entlang.