stereolli

- Registriert

- 19.11.05

- Beiträge

- 7.458

- Reaktionen

- 4.035

- Punkte

- 21.558

Mal was völlig irres :

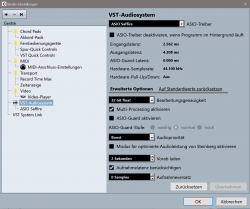

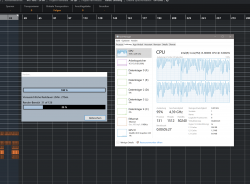

Mein Cubase Sx3.1 läuft mit eingeschaltetem Multiproz Unterstützung trotz Quadcore hakelig und mit hoher Cpu Last. Stelle ich die MultiprozUnterstützung aus, schnurrt er, wie er soll. Das soll man erstmal verstehen....

Mein Cubase Sx3.1 läuft mit eingeschaltetem Multiproz Unterstützung trotz Quadcore hakelig und mit hoher Cpu Last. Stelle ich die MultiprozUnterstützung aus, schnurrt er, wie er soll. Das soll man erstmal verstehen....